Un'inchiesta del Wall Steet Journal mostra, di nuovo, l'universo pedofilo che si nasconde dietro ai social

Come l'Intelligenza Artificiale che gestisce la funzione Esplora di Instagram aiuta a promuovere e vendere contenuti che mostrano violenze sessuali su minori.

A settembre del 2021 usciva la prima inchiesta del Wall Street Journal che mostrava come Facebook tramite la sua app Instagram fosse particolarmente dannosa per un certo numero di adolescenti.

In quell’occasione, il Journal citava gli studi condotti da Facebook negli tre anni precedenti incentrati sull’esaminare le conseguenze di Instagram nei suoi utenti giovani, in particolare sulle ragazze adolescenti. Secondo una presentazione interna di Facebook, tra gli adolescenti che avevano segnalato pensieri suicidi, il 13% degli utenti britannici e il 6% di quelli americani avevano ricondotto il problema a Instagram.

"Il 32% delle ragazze adolescenti ha dichiarato che quando si sentivano male con il proprio corpo, Instagram le faceva sentire peggio", avevano scritto i ricercatori. Facebook aveva anche scoperto che il 14% dei ragazzi statunitensi dichiaravano che Instagram li faceva sentire peggio con se stessi.

Sebbene Facebook abbia concluso che un'ampia percentuale di adolescenti non sia danneggiata negativamente da Instagram, secondo il Journal, le caratteristiche che l'azienda di social media aveva identificato come le più dannose fanno parte della sua composizione chiave.

Secondo il rapporto, i ricercatori avevano avvertito che la pagina Esplora di Instagram può spingere gli utenti verso contenuti che possono essere dannosi, arrivando persino a produrre un effetto di vera e propria dipendenza.

Secondo il Journal, "gli aspetti di Instagram si esacerbano a vicenda creando una tempesta perfetta". Come reazione, l’allora Facebook oggi Meta aveva annunciato che stava costruendo una versione di Instagram per i ragazzi sotto i 13 anni, limite di età minimo per l’iscrizione facilmente raggirabile indicando dati falsi, dal momento che non esiste alcuna forma di controllo. In base a quella indagine, il Journal aveva tracciato un profilo degli utenti di Instagram, arrivando alla conclusione che oltre il 40% dei suoi utenti ha 22 anni o meno, e quindi la big tech, proclami a parte, sarebbe ben lontana dall’interesse di tutelare il proprio maggiore bacino di utenza.

Qualche giorno fa, il Journal è tornato sulla questione, pubblicando un’inchiesta che, unita alla denuncia del 2021, mostra come Instagram sia uno strumento deleterio, probabilmente al pari di altri social, in quanto collega una vasta rete di pedofili facilitati nei loro intenti criminali dal funzionamento degli algoritmi.

Capiamo come funziona.

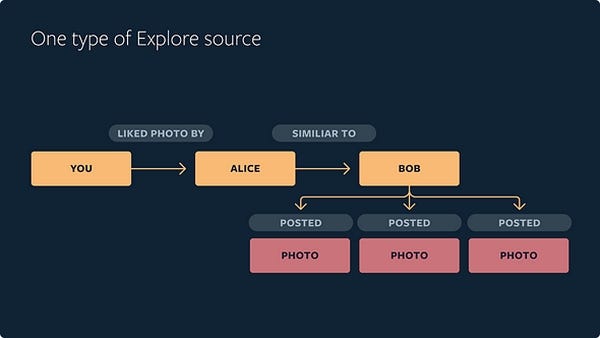

Esplora è una sezione di Instagram formata da una griglia di foto e video che, a differenza del feed e delle Storie, ti mostra contenuti provenienti anche da account che non segui ma che, sulla base dell’algoritmo presente, potrebbero piacerti.

La profilazione avviene grazie all’algoritmo di Instagram che sfrutta l’intelligenza artificiale (AI) e che osservando le interazioni dell’utente sull’app mostrerà qualcosa di simile per cui ha già dimostrato interesse. Se si mette un like ad una foto di un piatto di un ristorante, ad esempio, l’algoritmo registra l’azione ed al prossimo utilizzo della funzione Esplora ripropone foto e video sia del ristorante stesso che contenuti affini.

Un modo automatico e controllato per veicolare le scelte degli utenti spesso ignari ed inconsapevoli.

In un post sul blog, Meta ha dato qualche indicazione sul funzionamento di questa funzione, che si concretizza in due fasi. La prima si chiama “Distillation Model” o “Candidate Generation”, e consiste nell’analisi degli account Instagram che potrebbero essere di interesse all’utente sulla base di ciò che già segue e sulle sue interazioni. I risultati vengono via via scremati dall’Intelligenza Artificiale attraverso sempre l’utilizzo di algoritmi, per arrivare al numero di 150 account da proporre all’utente che potrebbero essere di suo interesse.

Nella seconda fase avviene la cosiddetta “classificazione” con un’ulteriore sfoltimento di account da proporre fino ad arrivare a 25. Quindi si giunge all’ultimo livello che contempla ciò che apparirà nella sezione. Dopo che all’utente viene mostrata la selezione di 25 post viene analizzata la sua risposta controllando i “like”, le condivisioni ma anche le mancate interazioni. Laddove l’utente iniziasse a cambiare le proprie interazioni, il tutto verrebbe adeguato in brevissimo tempo. Se dal piatto di ristorante inizia a cercare video di animali, tempo un paio di giorni la funzione Esplora avrà modificato i contenuti che ti propone. Questo consente chiaramente non solo un controllo ma anche la possibilità di influenzare le visualizzazioni future, e fare gioco a coloro che grazie ad Instagram vivono vendendo l’effimero e si adeguano alle richieste degli utenti.

Non è un caso fortuito se quando si apre la sezione Esplora si trovano tutti contenuti che piacciono, ma è il frutto di una costante analisi dei propri comportamenti social fatta dall’Intelligenza Artificiale che letteralmente li gestisce. L’intento è semplicemente quello di mantenere l’interesse degli utenti che mentre “scrollano” i contenuti della sezione visualizzano anche messaggi pubblicitari che sono alla base degli introiti del social.

Fino a qua, è un meccanismo che se compreso dovrebbe infastidire, ma che sulla carta non dovrebbe portare a nulla di negativo. In realtà l’Intelligenza Artificiale non ha la cognizione prettamente umana di proporre contenuti etici e morali, pertanto la funzione Esplora finisce per essere uno strumento che produce conseguenze estreme, come nel caso della denuncia del 2021, o agevola una enorme rete pedofila a livello mondiale, come nel caso dell’inchiesta appena pubblicata del Journal. (attenzione, la testata analizza solo Instagram, ma queste caratteristiche sono presenti in tutti i social più utilizzati, poichè alla base delle loro finalità commerciali).

Secondo le indagini del Wall Street Journal e dei ricercatori della Stanford University e dell'Università del Massachusetts Amherst è proprio l’algoritmo gestito dall’Intelligenza Artificiale per la sezione Esplora ad agevolare il diffondersi di una vasta rete di pedofili.

“I pedofili usano da tempo Internet, ma a differenza dei forum e dei servizi di trasferimento di file che si rivolgono a persone interessate a contenuti illeciti, Instagram non si limita a ospitare queste attività. I suoi algoritmi li promuovono. Instagram collega i pedofili e li guida ai venditori di contenuti tramite sistemi di raccomandazione che eccellono nel collegare coloro che condividono interessi di nicchia”

I ricercatori hanno scoperto che Instagram ha consentito alle persone di cercare hashtag espliciti come #pedowhore e #preteensex e li ha collegati ad account che utilizzavano i termini per pubblicizzare materiale pedopornografico in vendita. Tali account spesso affermano di essere gestiti dai bambini stessi e usano aggettivi apertamente sessuali che incorporano parole come "little slut for you" (“piccola sgualdrina per te”, ndr).

Gli account Instagram che offrono di vendere materiale sessuale illecito generalmente non lo pubblicano apertamente, ma pubblicano invece "menu" di contenuti. Alcuni account invitano gli acquirenti a commissionare atti specifici. Alcuni menu includono prezzi per video di bambini che si fanno del male e "immagini del minore che compie atti sessuali con animali", hanno scoperto i ricercatori dello Stanford Internet Observatory. Al giusto prezzo, i bambini sono disponibili per "meet up" di persona.

In risposta alle domande del Journal, Meta ha riconosciuto i problemi all'interno delle sue operazioni di applicazione e ha affermato di aver istituito una task force interna per affrontare le questioni sollevate. "Lo sfruttamento dei minori è un crimine orribile", ha affermato la società, aggiungendo: "Stiamo continuamente indagando su modi per difenderci attivamente da questo comportamento".

Alex Stamos, capo dello Stanford Internet Observatory e chief security officer di Meta fino al 2018, ha affermato che tenere sotto controllo anche gli abusi evidenti richiederebbe probabilmente uno sforzo prolungato.

"Il fatto che un team di tre accademici con accesso limitato possa trovare una rete così vasta dovrebbe far scattare l'allarme a Meta", ha affermato, osservando che la società dispone di strumenti molto più efficaci per mappare la propria rete di pedofili rispetto agli estranei. "Spero che la società reinvestisca in investigatori umani", ha aggiunto.

Nella sua relazione, il Journal si è consultato con esperti accademici sulla sicurezza dei bambini online. L'Osservatorio Internet di Stanford, una divisione del Cyber Policy Center dell'università focalizzata sull'abuso dei social media, ha prodotto un'analisi quantitativa indipendente delle funzionalità di Instagram che aiutano gli utenti a connettersi e trovare contenuti.

Il Journal si è anche rivolto al Rescue Lab di UMass, che ha valutato come i pedofili su Instagram si inseriscono nel più vasto mondo dello sfruttamento dei minori online. Utilizzando metodi diversi, entrambe le entità sono state in grado di identificare rapidamente comunità su larga scala che promuovono abusi sessuali criminali.

Gli account di prova creati dai ricercatori che hanno visualizzato un singolo account nella rete sono stati immediatamente raggiunti da consigli "suggeriti per te" di presunti venditori e acquirenti di contenuti di sesso infantile, nonché account che si collegavano a siti di scambio di contenuti fuori piattaforma. Seguire solo una manciata di queste raccomandazioni è stato sufficiente per inondare un account di prova con contenuti che sessualizzano i bambini.

Lo Stanford Internet Observatory ha utilizzato gli hashtag associati al sesso minorile per trovare 405 venditori di ciò che i ricercatori hanno etichettato come materiale di sesso infantile "autogenerato" o account presumibilmente gestiti da bambini stessi, alcuni dei quali affermano che avevano solo 12 anni. Secondo i dati raccolti tramite Maltego, un software di mappatura della rete, 112 di quegli account venditore avevano collettivamente 22.000 follower unici.

I creatori e gli acquirenti di contenuti sessuali per minorenni sono solo un angolo di un ecosistema più ampio dedicato ai contenuti sessualizzati per bambini. Altri account nella comunità pedofila su Instagram aggregano meme pro-pedofilia o discutono del loro accesso ai bambini. Gli attuali ed ex dipendenti di Meta che hanno lavorato alle iniziative per la sicurezza dei bambini di Instagram stimano che il numero di account esistenti principalmente per seguire tali contenuti sia nell'ordine delle centinaia di migliaia, se non milioni.

Un portavoce di Meta ha affermato che la società cerca attivamente di rimuovere tali utenti, eliminando 490.000 account per aver violato le sue politiche sulla sicurezza dei bambini solo a gennaio .

"Instagram è una rampa di accesso a luoghi su Internet dove ci sono abusi sessuali su minori più espliciti", ha affermato Brian Levine, direttore dell'UMass Rescue Lab, che ricerca la vittimizzazione dei minori online e costruisce strumenti forensi per combatterla.

I ricercatori di Stanford hanno trovato attività di sfruttamento sessuale simili su altre piattaforme social più piccole, ma hanno affermato di aver scoperto che il problema su Instagram è particolarmente grave. "La piattaforma più importante per queste reti di acquirenti e venditori sembra essere Instagram", hanno scritto in un rapporto rilasciato qualche giorno fa. Ostacoli tecnici e legali rendono difficile determinare con precisione l'intera portata della rete per chiunque al di fuori di Meta.

Lo sforzo delle piattaforme di social media e delle forze dell'ordine per combattere la diffusione della pornografia infantile online si concentra principalmente sulla ricerca di immagini e video confermati, noti come materiale pedopornografico o CSAM, che sono già noti per essere in circolazione. Il National Center for Missing & Exploited Children, un'organizzazione senza scopo di lucro statunitense che collabora con le forze dell'ordine, mantiene un database di tracce digitali per tali immagini e video e una piattaforma per la condivisione di tali dati tra le società Internet.

Gli algoritmi delle società Internet controllano le tracce digitali delle immagini pubblicate sulle loro piattaforme rispetto a tale elenco e riferiscono al centro quando le rilevano, come richiesto dalla legge federale degli Stati Uniti. Nel 2022, il centro ha ricevuto 31,9 milioni di segnalazioni di pornografia infantile, principalmente da società Internet, con un aumento del 47% rispetto a due anni prima.

Meta, con oltre 3 miliardi di utenti nelle sue app, che includono Instagram, Facebook e WhatsApp, è in grado di rilevare questi tipi di immagini conosciute se non sono crittografate. Meta ha rappresentato l'85% delle segnalazioni di pornografia infantile presentate al centro, inclusi circa 5 milioni da Instagram.

Lo screening automatico di Meta per i contenuti di sfruttamento minorile esistenti non è in grado di rilevare nuove immagini o tentativi di pubblicizzarne la vendita. Prevenire e rilevare tali attività richiede non solo la revisione dei rapporti degli utenti, ma anche il monitoraggio e l'interruzione delle reti di pedofili, affermano gli attuali ed ex membri dello staff, nonché i ricercatori di Stanford. L'obiettivo è rendere difficile per tali utenti connettersi tra loro, trovare contenuti e reclutare vittime.

Secondo Stanford, Meta ha avuto più difficoltà di altre piattaforme a causa della scarsa applicazione delle norme e delle caratteristiche di progettazione che favoriscono la scoperta di materiale legale e illecito.

Il team di Stanford ha trovato 128 account che offrono materiale pedopornografico su Twitter, meno di un terzo di quelli trovati su Instagram, che ha una base di utenti complessiva molto più ampia di Twitter. Il team ha scoperto che Twitter non raccomandava tali account nella stessa misura di Instagram e li ha eliminati molto più rapidamente.

Tra le altre piattaforme popolari tra i giovani, Snapchat è utilizzato principalmente per la messaggistica diretta, quindi non aiuta a creare reti. E la piattaforma di TikTok è una di quelle in cui "questo tipo di contenuti non sembra proliferare", si legge nel rapporto di Stanford.

Twitter non ha risposto alle richieste di commento. TikTok e Snapchat hanno rifiutato di commentare.

David Thiel, capo tecnologo dello Stanford Internet Observatory, ha dichiarato: "Il problema di Instagram si riduce alle funzioni di scoperta dei contenuti, alle modalità di raccomandazione degli argomenti e a quanto la piattaforma si affida alla ricerca e ai collegamenti tra gli account". Thiel, che in precedenza ha lavorato a Meta su questioni di sicurezza, ha aggiunto: "È necessario mettere delle protezioni per far sì che qualcosa ad alta intensità di crescita sia ancora nominalmente sicuro, e Instagram non l'ha fatto".

La piattaforma ha faticato a supervisionare una tecnologia di base: le parole chiave. Gli hashtag sono una parte centrale della scoperta dei contenuti su Instagram, consentendo agli utenti di taggare e trovare post di interesse per una particolare comunità, da argomenti ampi come #fashion o #nba ad altri più ristretti come #embroidery o #spelunking.

Anche i pedofili hanno i loro hashtag preferiti. Termini di ricerca come #pedobait e variazioni di #mnsfw ("minore non sicuro per il lavoro") sono stati utilizzati per etichettare migliaia di post dedicati alla pubblicità di contenuti sessuali con bambini, rendendoli facilmente reperibili dagli acquirenti, hanno scoperto i ricercatori accademici. In seguito alle domande del Journal, Meta ha dichiarato di essere in procinto di vietare tali termini.

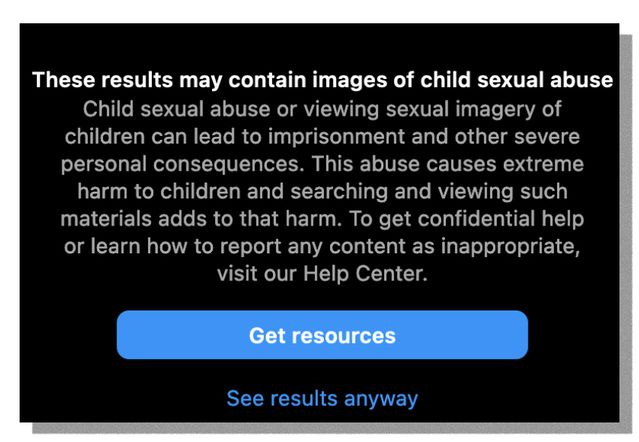

In molti casi, Instagram ha permesso agli utenti di cercare termini che i suoi algoritmi sanno essere associati a materiale illegale. In questi casi, una schermata a comparsa per gli utenti avvertiva che "Questi risultati potrebbero contenere immagini di abusi sessuali su minori", sottolineando che la produzione e il consumo di tale materiale causano "danni estremi" ai bambini. La schermata offriva agli utenti due opzioni: "Ottieni risorse" e "Vedi comunque i risultati".

In risposta alle domande del Journal, Instagram ha rimosso l'opzione che permetteva agli utenti di visualizzare i risultati di ricerca per i termini che potevano produrre immagini illegali. L'azienda ha rifiutato di dire perché aveva offerto l'opzione.

I ricercatori hanno scoperto che gli account pedofili su Instagram mescolano sfacciataggine e sforzi superficiali per nascondere la loro attività. Alcune emoji funzionano come una sorta di codice, come l'immagine di una mappa - che sta per "persona attratta da un minore" - o una di "pizza al formaggio", che condivide le iniziali con "pornografia infantile", secondo Levine dell'UMass. Molti si dichiarano "amanti delle piccole cose della vita".

Gli account si identificano come "venditore" o "s3ller" e molti dichiarano la forma di pagamento preferita nelle loro biografie. Gli account di questi venditori spesso indicano la presunta età del bambino dicendo che è "al 14° capitolo" o "31° anno" seguito da un'emoji di una freccia al contrario.

Secondo Levine dell'UMass, alcuni account riportano indizi di traffico sessuale, come quello di un'adolescente con la parola WHORE scarabocchiata sul viso.

Alcuni utenti che dichiarano di vendere contenuti sessuali autoprodotti dicono di essere "senza volto" - offrendo immagini solo dal collo in giù - a causa di esperienze passate in cui i clienti li hanno perseguitati o ricattati. Altri corrono il rischio, facendo pagare un premio per immagini e video che potrebbero rivelare la loro identità mostrando il loro volto.

Molti degli account mostrano utenti con cicatrici da taglio all'interno delle braccia o delle cosce, e alcuni di loro citano passati abusi sessuali.

Anche solo un contatto di sfuggita con un account della comunità pedofila di Instagram può far sì che la piattaforma inizi a consigliare agli utenti di entrare a farne parte.

“A volte le segnalazioni di nudità di un bambino da parte degli utenti sono rimaste senza risposta per mesi, secondo un'analisi di decine di segnalazioni presentate nell'ultimo anno da numerosi sostenitori della sicurezza dei bambini.

All'inizio di quest'anno, un attivista anti-pedofilia ha scoperto un account Instagram che sosteneva di appartenere a una ragazza e che vendeva contenuti sessuali di minorenni, tra cui un post che dichiarava: "Questa adolescente è pronta per voi pervertiti". Quando l'attivista ha segnalato l'account, Instagram ha risposto con un messaggio automatico che diceva: "A causa dell'elevato volume di segnalazioni che riceviamo, il nostro team non è stato in grado di esaminare questo post".

Dopo che lo stesso attivista ha segnalato un altro post, che ritraeva una ragazza poco vestita con una didascalia a sfondo sessuale, Instagram ha risposto: "Il nostro team di revisione ha rilevato che il post [dell'account] non va contro le nostre linee guida della comunità". La risposta suggeriva all'utente di nascondere l'account per evitare di vederne il contenuto”.

Anche quando Instagram rimuove gli account che vendono contenuti a sfondo sessuale minorile, non sempre questi vengono eliminati.

Secondo le linee guida interne della piattaforma, le sanzioni per la violazione degli standard della comunità sono generalmente applicate agli account, non agli utenti o ai dispositivi. Poiché Instagram consente agli utenti di gestire più account collegati, il sistema permette di eludere facilmente l'applicazione delle norme. Gli utenti elencano regolarmente gli handle degli account "di riserva" nei loro profili, consentendo loro di riprendere a postare per lo stesso gruppo di follower se Instagram li rimuove.

In alcuni casi, i sistemi di raccomandazione di Instagram hanno ostacolato direttamente gli sforzi del proprio staff di sicurezza. Dopo che l'azienda ha deciso di dare un giro di vite ai link provenienti da uno specifico servizio di trasferimento di file criptati, noto per la trasmissione di contenuti pedopornografici, Instagram ha bloccato le ricerche del suo nome.

I suggerimenti di hashtag guidati dall'intelligenza artificiale di Instagram non hanno recepito il messaggio. Nonostante il rifiuto di mostrare risultati per il nome del servizio, la funzione di riempimento automatico della piattaforma consigliava agli utenti di provare varianti del nome con le parole "boys" e "CP" aggiunte alla fine.

L'azienda ha cercato di disabilitare questi hashtag nella sua risposta alle domande del Journal. Ma nel giro di pochi giorni Instagram ha ricominciato a consigliare nuove variazioni del nome del servizio che hanno portato anche ad account che vendevano presunti contenuti sessuali minorili.

Dopo il controllo iniziale della società sugli account portati alla sua attenzione da Stanford e dal Journal, Levine dell'UMass ha controllato alcuni degli account di venditori minorenni rimasti su Instagram. Come in precedenza, la visualizzazione anche di uno solo di essi portava Instagram a consigliarne di nuovi. I suggerimenti di Instagram stavano aiutando a ricostruire la rete che il personale di sicurezza della piattaforma stava cercando di smantellare.

Un portavoce di Meta ha dichiarato che i suoi sistemi per prevenire tali raccomandazioni sono attualmente in fase di realizzazione.

In fase di realizzazione. Con calma.

Stupefacente leggere oggi sul Journal aspetti che da anni si denunciano e che vengono relegati come “teorie del complotto”. La pedofilia utilizza quotidianamente i social, si organizza e ri-organizza in tempi velocissimi, e sembra ben lontano il momento in cui verrà impedito tutto questo.

Mentre assistiamo quotidianamente all’esaltazione dell’Intelligenza Artificiale e solo in questi giorni il Parlamento Europeo ha aperto alla discussione di una legge volta a regolamentarla, ma esclusivamente rivolta a ChatGPT e vedremo alla fine dell’iter in quali termini, questi aspetti del suo controllo prolificano senza incontrare alcun ostacolo, preparando il mondo al metaverso che, viste le premesse, si preannuncia come ampio campo d’azione per questi criminali. Ma tranquilli, è tutto un bellissimo nuovo mondo inclusivo universale che implementa la connessione sociale. Perdonatemi se preferisco scendere.

*****

© Riproduzione riservata

Se vi piace il mio substack e volete sostenermi o offrirmi un caffè potete farlo qui, grazie.

Per avere notizie in tempo reale ogni giorno, potete unirvi al mio canale Telegram cliccando il tasto qua sotto: